일라이자 효과

일라이자 효과(ELIZA effect)는 컴퓨터 과학에서 컴퓨터 프로그램에 경험, 이해, 공감 등의 인간적 특성을 투영하는 경향을 말한다. 주로 텍스트 인터페이스가 있는 챗봇의 반응을 인간의 것으로 받아들이는 경향을 가리키지만, 컴퓨터가 작동하는 영역 전반을 무언가 "생각하다", "알다" 또는 "이해하다"와 같은 용어를 통해 의인화하여 설명할 때 발생하는 범주오류를 뜻하기도 한다.

일라이자 효과의 발견은 인공지능의 개발에 중요하였으며, 튜링 테스트를 통과하기 위해 명시적 프로그래밍이 아닌 사회공학을 이용한 원리를 입증하였다.[1]

기원 편집

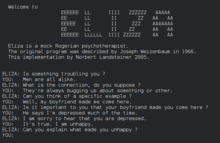

1966년 매사추세츠 공과대학교의 컴퓨터 과학자 조셉 와이젠바움은 챗봇 일라이자(ELIZA)를 개발하였다. 일라이자는 설계된 스크립트에 따라 사용자가 입력한 문장을 바탕으로 답변을 생성하는 기능을 가졌다. 와이젠바움은 이를 이용하여 인간 중심 상담의 심리요법을 시뮬레이션하는 DOCTOR 스크립트를 구성하였다.[2]

- 인간: 글쎄요, 제 남자 친구가 여기 오라고 했어요.

- 일라이자: 남자 친구가 당신을 여기 오게 했다고요?

- 인간: 내가 거의 늘 우울해 한다고 하더군요.

- 일라이자: 당신이 우울하다는 소식을 들으니 안타깝습니다.

- 인간: 그래요, 나는 불행해요.

- 엘리자: 여기 오는 것이 불행하지 않게 되는 데 도움이 된다고 생각하세요?

일라이자는 엄밀히 말하면 "자연어 대화"를 지원하는 메커니즘일 뿐이었지만[3] DOCTOR 스크립트는 상호 작용에서 사람들의 감정적 반응을 이끌어내는데 놀랍도록 성공적이었고 사용자의 몰입을 유도하였다.[4] 훗날 와이젠바움은 자신의 비교적 간단한 컴퓨터 프로그램이 평범한 사람들에게 짧은 시간의 노출 만으로도 그토록 망상적 사고를 유발할 수 있게 될 줄은 당시로선 알 수 없었다고 회고하였다.[5] 일라이자의 코드는 이러한 반응을 예상치 못하고 설계되었지만, 일라이자의 되묻는 질문에 사람들은 관련 주제에 대한 관심과 감정적인 반응을 보였다. 이러한 반응은 일라이자가 실은 그와 관련한 어떠한 감정도 없는 프로그램 코드일 뿐임을 명백히 알고 쓴 사용자에게서도 일어났다.[6]

1960년대에 이미 일라이자 효과라는 용어가 쓰이기 시작하였고 찰스 배비지는 기계적 작동을 심리적 용어로 이해하려는 경향에 대해 주목하였다. 베비지는 훗날 자리올림수 예측 가산기로 불리게 된 개념을 제안하면서 실제로는 그저 기계적 동작에 불과한 것을 설명하는데 이러한 용어들이 편리하다는 점을 발견하였다.[7]

특징 편집

좁은 의미에서 일라이자 효과는 "특히 단어와 같이 컴퓨터로 엮은 일련의 기호를 읽는 사람들이 그 보다 훨씬 많은 이해를 보이는 감수성"만을 의미한다.[8] 즉, 기계가 아니라 그것을 대하는 사람들이 보이는 특징을 말한다. 더글러스 호프스태터는 현금 자동 입출금기가 거래 종료시 표시하는 "감사합니다"와 같은 문구를 예로 든다. 이 문구는 그저 프로그램에 의해 자동 재생되는 것에 불과하지만, 이용하는 사람들은 마치 은행원과의 거래를 마칠 때 주고 받는 말과 같은 느낌을 받는다.[8]

보다 넓은 의미에서 일라이자 효과는 사람들이 스스로의 상상에 의해 소프트웨어의 결과물을 실제로는 결코 도달할 수 없는 품질로 인식하는 모든 상황을 뜻한다.[9][10] 이는 사람들이 기계적 출력을 인식하면서 실제 결과물보다 더 많은 연관성을 가정하기 때문이다.[11]

어느 경우에서건 사람들이 실제로 작동하는 방식과 결과물의 특징을 잘 알고 있는 경우에도 일라이자 효과가 발생하였다는 점에서 주목할만 하다. 심리적 관점에서 볼 때 일라이자 효과는 사람들이 프로그램의 한계를 자신의 상상으로 메우는 미묘한 인지 부조화의 결과이다.[12]

중요성 편집

일라이자 효과는 튜링 테스트를 통과하였다고 평가되는 인공 지능이 실제 프로그램의 작동보다 사회공학에 기초한다는 점을 입증하였다.[13]

일라이자를 사용한 사람들 가운데 일부는 인간과 대화하고 있다고 생각하였다. 기계와 인간의 상호 작용에서 나타난 이러한 변화는 이후 기계의 인간 모방 기술에 영향을 주었다. 윌리엄 메이셀은 쳇봇을 단순한 메모 작성과 일정 확인 등의 기능을 가진 일반형 개인 비서 챗봇과 특정 영역에서 작동하는 전문적 작업 보조 챗봇으로 구분하고 후자의 경우 인간의 행동을 예측한 프로그래밍이 생산성 향상에 도움이 될 것이라 예측하였다.[14]

한편 와이젠바움은 인간 사고의 모든 부분이 논리적 형식주의로 축소될 수는 없으며 "오직 인간만이 시도하는 사고 행위가 있다"고 보았다.[15] 인간이기 때문에 상대하는 것이 기계임을 아는 경우에도 인간의 방식으로 상호 작용이 일어난다는 것이다. 챗봇이 의인화되면 인간에게 주어지는 특징이 기계에게도 투영된다. 예를 들면 개인 비서용 챗봇의 성별을 여성으로 설정하거나 하는 방식으로 "성별 고정관념"이 투영되며, 이는 챗봇과의 관계를 관리하기 위해 도구화된다.[16]

1990년대에 클리포드 내스와 바이런 리브스는 사람들이 미디어를 접하면서 마치 사람에게 하듯이 반응하는 경향이 있음을 지적하였다. 사람들은 미디어가 전하는 콘텐츠에 대해 공손함, 협조, 공격, 유머, 전문 지식의 습득, 성별 고정관념 등등의 반응을 보인다. 사회학과 심리학 등의 간학문적 연구에서는 인간의 이러한 반응이 자동적이며 피할 수 없고 생각보다 흔히 일어난다는 점을 발견하였다. 내스와 리브스의 1996년 연구는 "퍼스널 컴퓨터, 텔레비전, 뉴미디어와의 상호작용은 실생활에서의 상호작용과 같이 근본적으로 사회적이며 자연스럽다"고 주장한다.

이는 사회적 고정관념의 강화로도 이어질 수 있다. 예를 들어 디지털 비서 프로로그램은 대개 여성으로 설정되며, 이는 "여성이 서비스 노동과 감정 노동에 대한 자연스러운 친화력을 가지고 있다는 가정"을 강화한다.[17] 사용자들도 이에 맞추어 자연스럽게 비서 프로그램을 여성으로 대하지만, 실제 작동하는 프로그램은 이러한 반응과 아무런 연관이 없는 기계적 동작만을 수행할 뿐이다.

같이 보기 편집

각주 편집

- ↑ Trappl, Robert; Petta, Paolo; Payr, Sabine (2002). 《Emotions in Humans and Artifacts》. Cambridge, Mass.: MIT Press. 353쪽. ISBN 978-0-262-20142-1.

The "Eliza effect" — the tendency for people to treat programs that respond to them as if they had more intelligence than they really do (Weizenbaum 1966) is one of the most powerful tools available to the creators of virtual characters.

- ↑ Güzeldere, Güven; Franchi, Stefano. “dialogues with colorful personalities of early ai”. 2011년 4월 25일에 원본 문서에서 보존된 문서. 2007년 7월 30일에 확인함.

- ↑ Weizenbaum, Joseph (January 1966). “ELIZA--A Computer Program For the Study of Natural Language Communication Between Man and Machine”. 《Communications of the ACM》 (Massachusetts Institute of Technology) 9: 36. doi:10.1145/365153.365168. 2008년 6월 17일에 확인함.

- ↑ Suchman, Lucy A. (1987). 《Plans and Situated Actions: The problem of human-machine communication》. Cambridge University Press. 24쪽. ISBN 978-0-521-33739-7. 2008년 6월 17일에 확인함.

- ↑ Weizenbaum, Joseph (1976). 《Computer power and human reason: from judgment to calculation》. W. H. Freeman. 7쪽.

- ↑ Billings, Lee (2007년 7월 16일). “Rise of Roboethics”. Seed. 2009년 2월 28일에 원본 문서에서 보존된 문서.

(Joseph) Weizenbaum had unexpectedly discovered that, even if fully aware that they are talking to a simple computer program, people will nonetheless treat it as if it were a real, thinking being that cared about their problems – a phenomenon now known as the 'Eliza Effect'.

- ↑ Green, Christopher D. (February 2005). “Was Babbage's Analytical Engine an Instrument of Psychological Research?”. 《History of Psychology》 8: 35–45.

- ↑ 가 나 Hofstadter, Douglas R. (1996). 〈Preface 4 The Ineradicable Eliza Effect and Its Dangers, Epilogue〉. 《Fluid Concepts and Creative Analogies: Computer Models of the Fundamental Mechanisms of Thought》. Basic Books. 157쪽. ISBN 978-0-465-02475-9.

- ↑ Fenton-Kerr, Tom (1999). 〈GAIA: An Experimental Pedagogical Agent for Exploring Multimodal Interaction〉. 《Computation for Metaphors, Analogy, and Agents》. Lecture Notes in Computer Science 1562. Springer. 156쪽. doi:10.1007/3-540-48834-0_9. ISBN 978-3-540-65959-4.

Although Hofstadter is emphasizing the text mode here, the "Eliza effect" can be seen in almost all modes of human/computer interaction.

- ↑ Ekbia, Hamid R. (2008). 《Artificial Dreams: The Quest for Non-Biological Intelligence》. Cambridge University Press. 8쪽. ISBN 978-0-521-87867-8.

- ↑ Rouse, William B.; Boff, Kenneth R. (2005). 《Organizational Simulation》. Wiley-IEEE. 308–309쪽. ISBN 978-0-471-73943-2.

This is a particular problem in digital environments where the "Eliza effect" as it is sometimes called causes interactors to assume that the system is more intelligent than it is, to assume that events reflect a greater causality than they actually do.

- ↑ Ekbia, Hamid R. (2008). 《Artificial Dreams: The Quest for Non-Biological Intelligence》. Cambridge University Press. 156쪽. ISBN 978-0-521-87867-8.

But people want to believe that the program is "seeing" a football game at some plausible level of abstraction. The words that (the program) manipulates are so full of associations for readers that they CANNOT be stripped of all their imagery. Collins of course knew that his program didn't deal with anything resembling a two-dimensional world of smoothly moving dots (let alone simplified human bodies), and presumably he thought that his readers, too, would realize this. He couldn't have suspected, however, how powerful the Eliza effect is.

- ↑ Trappl, Robert; Petta, Paolo; Payr, Sabine (2002). 《Emotions in Humans and Artifacts》. Cambridge, Mass.: MIT Press. 353쪽. ISBN 978-0-262-20142-1.

The "Eliza effect" — the tendency for people to treat programs that respond to them as if they had more intelligence than they really do (Weizenbaum 1966) is one of the most powerful tools available to the creators of virtual characters.

- ↑ Dale, Robert (September 2016). “The return of the chatbots”. 《Natural Language Engineering》 (영어) 22 (5): 811–817. doi:10.1017/S1351324916000243. ISSN 1351-3249.

- ↑ Weizenbaum, Joseph (1976). 《Computer power and human reason : from judgment to calculation》. San Francisco, Cal. ISBN 0-7167-0464-1. OCLC 1527521.

- ↑ Costa, Pedro. Ribas, Luisa. Conversations with ELIZA: on Gender and Artificial Intelligence. From (6th Conference on Computation, Communication, Aesthetics & X 2018) Accessed February 2021

- ↑ Hester, Helen. 2016. "Technology Becomes Her." New Vistas 3 (1):46-50.

참고 문헌 편집

- Hofstadter, Douglas. Preface 4: The Ineradicable Eliza Effect and Its Dangers. (from Fluid Concepts and Creative Analogies: Computer Models of the Fundamental Mechanisms of Thought, Basic Books: New York, 1995)

- Turkle, S., Eliza Effect: tendency to accept computer responses as more intelligent than they really are (from Life on the screen- Identity in the Age of the Internet, Phoenix Paperback: London, 1997)

- ELIZA effect, from the Jargon File, version 4.4.7. Accessed 8 October 2006.

- Byron Reeves & Clifford Nass. The Media Equation: How People Treat Computers, Television, and New Media like Real People and Places, Cambridge University Press: 1996.